Tin công nghệ, Tin tức

Chip AI mới đánh bại Nvidia, AMD và Intel với tốc độ nhanh hơn 20 lần và hơn 4 nghìn tỷ bóng bán dẫn

Một sự thay đổi lớn đang diễn ra trên thị trường phần cứng trí tuệ nhân tạo do một đối thủ mới thúc đẩy: Cerebras Systems. Gần đây, công ty khởi nghiệp có trụ sở tại California đã công bố ra mắt Cerebras Inference, một giải pháp đột phá được cho là nhanh hơn 20 lần so với GPU của Nvidia (NVDA) .

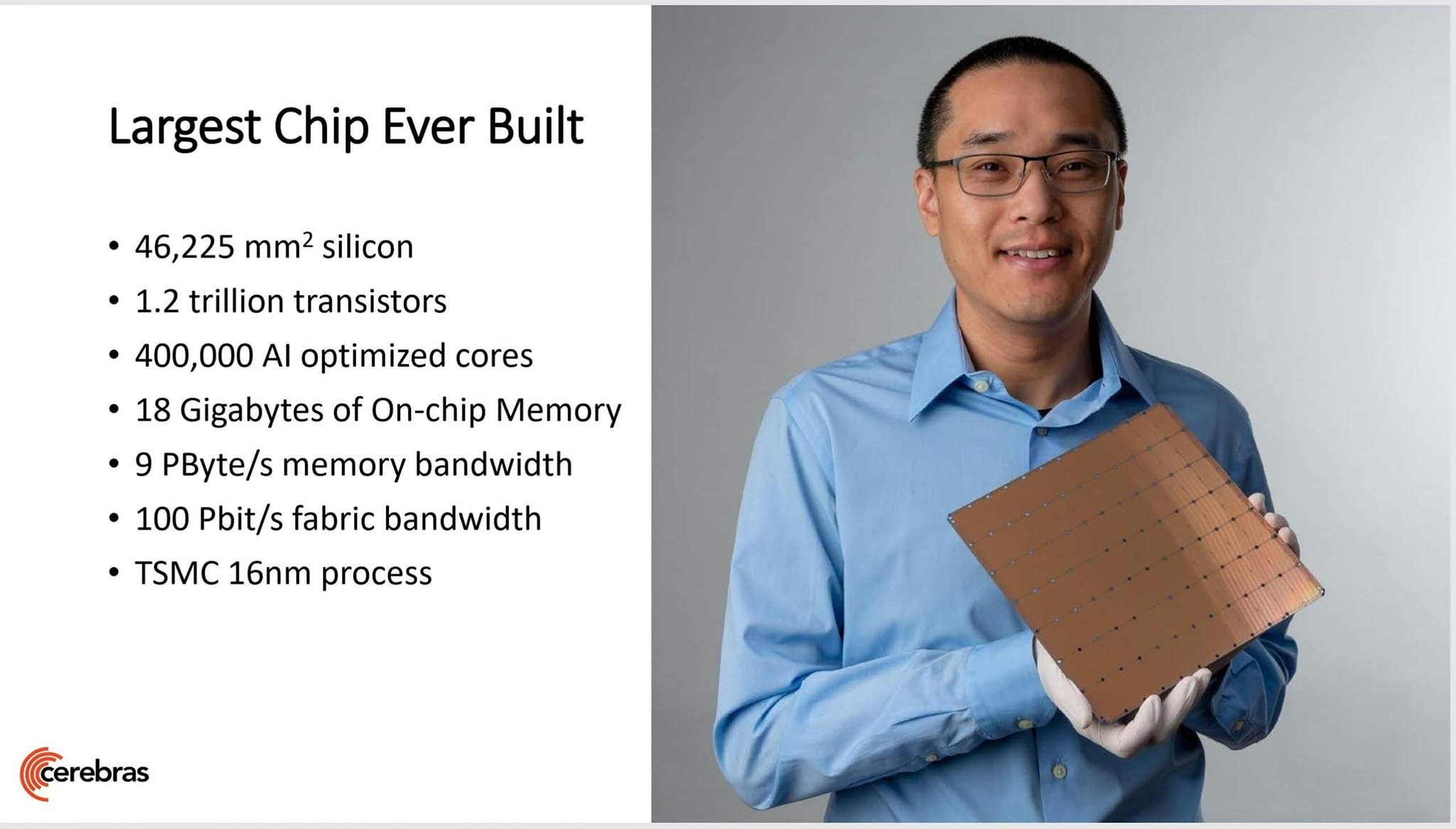

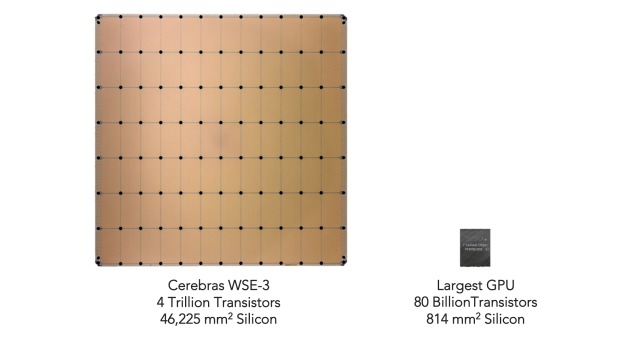

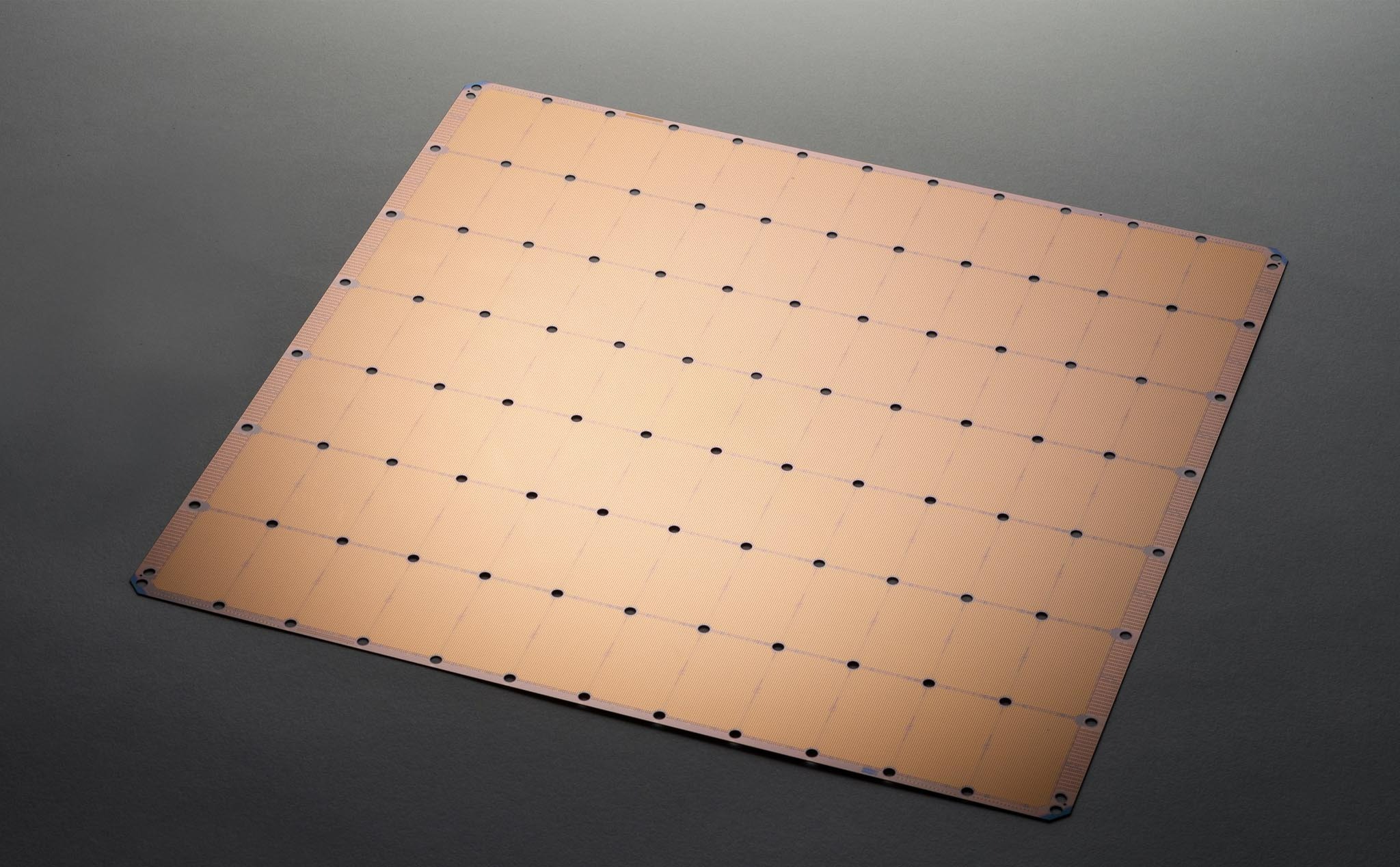

Cerebras đã phát triển cái mà họ gọi là Wafer Scale Engine, thế hệ thứ 3 của nó cung cấp năng lượng cho Cerebras Inference mới. Con chip khổng lồ này tích hợp 44GB SRAM và loại bỏ nhu cầu về bộ nhớ ngoài, vốn là một nút thắt cổ chai đáng kể trong các thiết lập GPU truyền thống. Bằng cách giải quyết vấn đề băng thông bộ nhớ, Cerebras Inference có thể cung cấp 1.800 token mỗi giây cho Llama3.1 8B và 450 token cho Llama3.1 70B, thiết lập các tiêu chuẩn mới của ngành về tốc độ.

Đối với các nhà đầu tư và những người đam mê công nghệ, sự so sánh giữa Cerebras và các nhà sản xuất chip hàng đầu như Nvidia, AMD (AMD) và Intel (INTC) ngày càng trở nên có liên quan. Trong khi Nvidia từ lâu đã thống trị các lĩnh vực AI và học sâu với các giải pháp GPU mạnh mẽ của mình, thì sự gia nhập của Cerebras với một công nghệ riêng biệt và có khả năng vượt trội có thể phá vỡ động lực thị trường. Hơn nữa, AMD và Intel, cả hai đều là những công ty lớn trong ngành chip, cũng có thể cảm thấy áp lực khi chip Cerebras bắt đầu tạo ra một vị trí thích hợp trong các tác vụ AI hiệu suất cao.

So sánh chip Cerebras với Nvidia

Mục lục

Khi so sánh chip Cerebras với GPU của Nvidia, cần phải xem xét một số khía cạnh chính về hiệu suất phần cứng, thiết kế kiến trúc, tính phù hợp của ứng dụng và tác động đến thị trường.

Thiết kế kiến trúc

Cerebras: Cerebras nổi tiếng với Wafer Scale Engine, đúng như tên gọi, được xây dựng trên một wafer khổng lồ duy nhất. Động cơ wafer-scale mới nhất có khoảng 4 nghìn tỷ bóng bán dẫn và tích hợp 44GB SRAM trực tiếp trên chip. Thiết kế này loại bỏ nhu cầu về bộ nhớ ngoài, do đó loại bỏ tình trạng tắc nghẽn băng thông bộ nhớ cản trở kiến trúc chip truyền thống. Cerebras tập trung vào việc tạo ra con chip lớn nhất và mạnh mẽ nhất có thể lưu trữ và xử lý các mô hình AI khổng lồ trực tiếp trên wafer, giúp giảm đáng kể độ trễ liên quan đến tính toán AI.

Nvidia: Kiến trúc của Nvidia dựa trên phương pháp tiếp cận đa đế, trong đó nhiều đế GPU được kết nối thông qua các liên kết tốc độ cao như NVLink. Thiết lập này, được thấy trong các sản phẩm mới nhất của họ như máy chủ DGX B200, cho phép tiếp cận theo mô-đun và có thể mở rộng nhưng liên quan đến việc phối hợp phức tạp giữa nhiều chip và nhóm bộ nhớ. Các chip của Nvidia, như B200, có sức mạnh đáng kể với hàng tỷ bóng bán dẫn và được tối ưu hóa cho cả nhiệm vụ đào tạo AI và suy luận, tận dụng kiến trúc GPU tiên tiến đã được tinh chỉnh trong nhiều năm.

Hiệu suất

Cerebras: Hiệu suất của chip Cerebras mang tính đột phá trong các tình huống cụ thể, đặc biệt là suy luận AI, khi chip có thể xử lý dữ liệu đầu vào ở tốc độ được báo cáo là nhanh hơn 20 lần so với các giải pháp của Nvidia. Điều này là do tích hợp trực tiếp bộ nhớ và sức mạnh xử lý, cho phép truy xuất và xử lý dữ liệu nhanh hơn mà không có độ trễ truyền dữ liệu giữa các chip.

Nvidia: Mặc dù Nvidia có thể tụt hậu so với Cerebras về tốc độ suy luận thô trên mỗi chip, nhưng GPU của hãng này cực kỳ linh hoạt và được coi là tiêu chuẩn công nghiệp trong nhiều ứng dụng khác nhau, từ chơi game đến các tác vụ đào tạo AI phức tạp. Điểm mạnh của Nvidia nằm ở hệ sinh thái và ngăn xếp phần mềm mạnh mẽ và được áp dụng rộng rãi, giúp GPU của hãng có hiệu quả cao đối với nhiều tác vụ AI.

Tính phù hợp của ứng dụng

Cerebras: Chip Cerebras đặc biệt phù hợp với các doanh nghiệp cần xử lý cực nhanh các mô hình AI lớn, chẳng hạn như các mô hình được sử dụng trong xử lý ngôn ngữ tự nhiên và các tác vụ suy luận học sâu. Hệ thống của họ lý tưởng cho các tổ chức muốn giảm độ trễ xuống mức tối thiểu và cần xử lý khối lượng lớn dữ liệu theo thời gian thực.

Nvidia: GPU của Nvidia linh hoạt hơn và có thể xử lý nhiều tác vụ, từ dựng hình đồ họa trong trò chơi điện tử đến đào tạo các mô hình AI phức tạp và chạy mô phỏng. Tính linh hoạt này khiến Nvidia trở thành lựa chọn hàng đầu cho nhiều lĩnh vực, không chỉ những lĩnh vực tập trung vào AI.

Phần kết luận

Trong khi Cerebras cung cấp hiệu suất vượt trội trong các tác vụ AI cao cấp cụ thể, Nvidia cung cấp tính linh hoạt và hệ sinh thái mạnh mẽ. Sự lựa chọn giữa Cerebras và Nvidia sẽ phụ thuộc vào các trường hợp sử dụng và yêu cầu cụ thể. Đối với các tổ chức xử lý các mô hình AI cực lớn, nơi tốc độ suy luận là rất quan trọng, Cerebras có thể là lựa chọn tốt hơn. Trong khi đó, Nvidia vẫn là một đối thủ mạnh mẽ trên nhiều ứng dụng, cung cấp tính linh hoạt và độ tin cậy với hệ sinh thái hỗ trợ phần mềm toàn diện.

Những mẫu Microsoft Surface đáng mua nhất trong năm 2024.

Dịch vụ sửa chữa Surface uy tín, lấy ngay tại Hà Nội, HCM, Đà Nẵng.